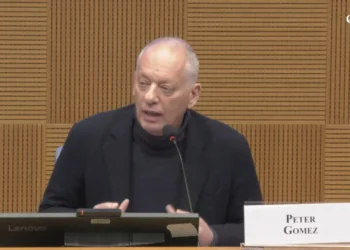

Por Marco Severini — Espresso Italia

Relatos crescentes de utilizadores da plataforma X, anteriormente Twitter, indicam uma prática sistemática de restrição de visibilidade e remoção de publicações quando aparecem termos como “sionismo”, “EUA-Israel” ou combinações que envolvem “Epstein” e Israel. Desde a aquisição por Elon Musk, em 2022, o anúncio de uma nova era de liberdade de expressão parecia reposicionar a rede social como uma praça pública digital. Contudo, o panorama emergente denuncia um jogo estratégico mais complexo do que a simples abolição da moderação.

Fontes e relatos de usuários apontam que, com a integração crescente da inteligência artificial Grok ao mecanismo de operação da plataforma, a penalização — popularmente identificada como shadowban — não desapareceu: ela foi reestruturada, graduada e, segundo os queixosos, normalizada como funcionalidade. Ou seja, não se trataria de um erro técnico isolado, mas de um movimento deliberado no tabuleiro da moderação.

Documentos e análises preliminares sobre o algoritmo da rede descrevem categorias classificadas como “sensíveis”. Entre elas figuram as chamadas “teorias da conspiração”, cuja definição inclui, entre outros, conteúdos que sugerem ligações entre figuras controversas e Estados ou grupos específicos — por exemplo, alegações envolvendo Epstein e Israel. Outra etiqueta relevante é a de “anti-sionismo”, que abrange críticas às políticas do Estado israelense quando formuladas com termos como “genocídio”, “apartheid” ou “limpeza étnica”. Nessa moldura, até o sarcasmo dirigido a contas pró-Israel pode ser enquadrado em categorias de “desumanização e estereotipação”.

Do ponto de vista estratégico, o fenômeno ilustra a tensão entre três alicerces: a retórica da liberdade de expressão, as exigências regulatórias e o imperativo comercial das plataformas. A promessa inicial de eliminação da moderação algorítmica transformou-se em um redesenho das fronteiras — invisíveis porém eficazes — que regulam o fluxo informacional. Para atores do espectro geopolítico, essa tectônica de poder redefine não apenas debates públicos, mas também a capacidade de influência de comunidades inteiras.

Usuários afetados relatam que, ao interrogarem o próprio sistema via respostas automatizadas da IA, receberam confirmações de penalização: não se trata de um simples “bug”, sustentam alguns especialistas técnicos, mas de uma função projetada para modular alcance e engajamento. A graduação dessas sanções — menos visível que uma eliminação direta — torna a medida mais difícil de auditar e contestar.

Em termos práticos e políticos, resta a pergunta sobre critérios e transparência. Quais são as linhas que separam crítica legítima de conteúdo perigoso? Quem interpreta e valida essas fronteiras quando a autoridade interpretativa é parcialmente delegada a modelos de linguagem?

Na arena internacional, onde narrativas competem por legitimidade, qualquer alteração nos mecanismos de visibilidade equivale a um movimento decisivo no tabuleiro: altera alianças, desestabiliza discursos e pode enfraquecer ou fortalecer vetores de pressão política. A solução exigirá, ao mesmo tempo, claridade técnica, supervisão independente e um debate público informado sobre os limites da moderação algorítmica.

Enquanto isso, os usuários e observadores seguem avaliando criticamente os novos parâmetros da plataforma. As vítimas das penalizações pedem auditorias, relatórios públicos e a reelaboração de políticas que hoje parecem ter alicerces frágeis demais para lidar com a complexidade dos debates contemporâneos.