Por Stella Ferrari — A combinação entre ciência de dados de ponta e observação astronômica acelerou a descoberta em um ritmo que lembra a aceleração de um motor afinado: a Agência Espacial Europeia (ESA) utilizou inteligência artificial para varrer décadas de imagens do Telescópio Espacial Hubble e revelou centenas de sinais inesperados. O estudo, assinado por David O’Ryan e Pablo Gómez e publicado em Astronomy & Astrophysics, demonstra a capacidade de algoritmos para ampliar o alcance da investigação observacional.

O projeto treinou uma rede neural batizada de AnomalyMatch com o Hubble Legacy Archive, um repositório que acumula observações ao longo de 35 anos. Em um processo de elevada calibragem e eficiência computacional, o sistema analisou quase 100 milhões de recortes de imagens e completou a varredura em cerca de dois dias e meio — um feito que, em termos operacionais, equivale a levar dezenas de anos-luz de dados ao ritmo de uma transmissão de alta performance.

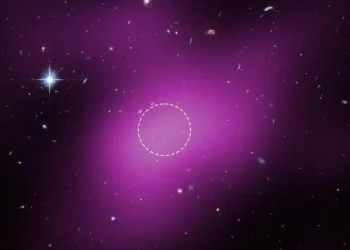

As anomalias com maior probabilidade de serem reais foram então checadas manualmente. Do total verificado, os pesquisadores confirmaram mais de 1.300 anomalias reais; entre elas, mais de 800 anomalias inéditas — sinais que não constavam na literatura científica até agora. A maioria refere-se a galáxias em interação, com morfologias distorcidas e vestígios de estrelas e gás, mas a lista inclui também lentes gravitacionais que curvam a luz de objetos mais distantes em arcos e anéis, galáxias em anel, e exemplos de jellyfish galaxies com longos “tentáculos” de gás.

Foram identificados ainda discos protoplanetários vistos de perfil e, em alguns casos, objetos que fogem às categorias conhecidas — potenciais alvos para investigação detalhada. O trabalho evidencia que, diante de massas de dados tão volumosas, a inteligência artificial não substitui o olhar humano, mas amplifica sua capacidade de triagem e priorização.

Para a ESA, o sucesso do AnomalyMatch é um ensaio prático sobre como maximizar o rendimento científico de grandes arquivos na era dos dados. Missões e observatórios em operação ou vindouros — como Euclid, o Vera C. Rubin Observatory e o futuro Nancy Grace Roman Space Telescope — vão produzir fluxos de informação que exigirão essa mesma combinação de inteligência computacional e verificação humana. Em termos estratégicos, trata-se de uma recalibragem do pipeline científico: algoritmos para escanear e priorizar; especialistas para interpretar e validar.

Como economista e estrategista, vejo esse avanço como uma mudança de marcha no design de políticas científicas e investimentos em infraestrutura de dados. A aceleração promovida pela IA reduz o tempo entre observação e descoberta — e, consequentemente, otimiza o retorno científico e tecnológico de instrumentos caros como o Hubble. A próxima etapa é integrar essa eficiência aos processos de publicação, follow-up observacional e financiamento, garantindo que as anomalias identificadas se transformem em conhecimento.