Enquanto as cidades brilham com as luzes das festas, uma névoa digital está se espalhando silenciosamente pelas telas: os deepfakes. No final de 2025, a linha entre o que é real e o que é gerado por inteligência artificial tornou-se mais tênue do que nunca. Entre mensagens de felicitações e o fluxo contínuo das redes sociais, vivemos uma nova fase da desinformação, onde um vídeo falso não é prova e uma imagem falsa pode ser um espejismo algorítmico.

Para entender a dimensão do problema, basta lembrar o que aconteceu nas eleições presidenciais na Irlanda, em outubro: um vídeo de Catherine Connolly anunciando sua suposta retirada, com a voz embargada, circulou como se fosse autêntico. O material ficou no ar por seis horas decisivas e acumulou milhões de visualizações antes que a verdade se impusesse. Esse episódio demonstra que o risco do deepfake é tanto tecnológico quanto temporal — a IA explora momentos em que nossa vigilância está reduzida, como fins de semana ou feriados.

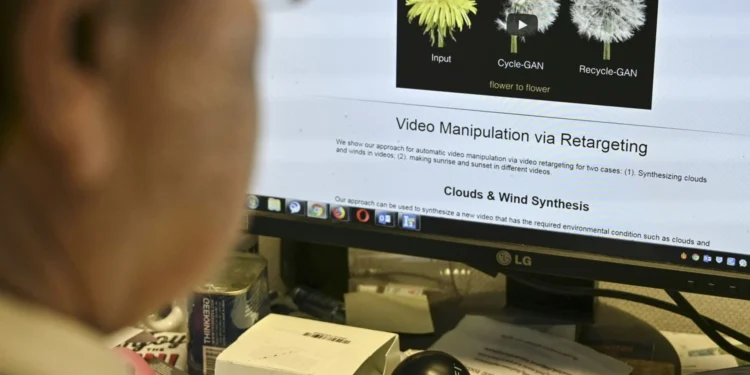

Como analista que observa a infraestrutura digital, costumo comparar esses ataques a uma falha no sistema nervoso das cidades: pequenos ruídos que, se não detectados, interferem nos fluxos de decisão coletiva. A primeira linha de defesa continua sendo a verificação de fontes, mas existem sinais práticos, observáveis com um olhar técnico, que ajudam a identificar conteúdos gerados por máquina.

Imagens: a IA é excelente na estética, mas ainda comete erros de física. Verifique as sombras — frequentemente caem em direções inconsistentes ou desaparecem sob o queixo. Observe a perspectiva: em fotos reais, linhas paralelas convergem para pontos de fuga coerentes; em imagens sintéticas, há irregularidades geométricas nos fundos.

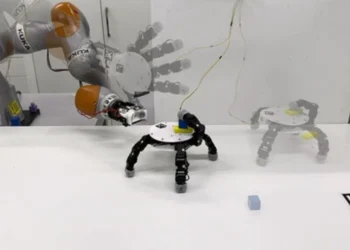

Mãos e joias: a anatomia é um ponto fraco: conte os dedos, examine o posicionamento e a simetria de anéis e brincos; algoritmos tendem a gerar assimetrias estranhas.

Olhos e reflexos: o brilho nas pupilas costuma ser idêntico em fotos autênticas; em deepfakes os reflexos são frequentemente assimétricos ou ausentes, dando um olhar “vítreo”.

Textos nos fundos: placas e rótulos gerados por IA podem parecer legíveis à primeira vista, mas se olhar de perto são frequentemente um amontoado de caracteres sem sentido.

Vídeos: há checagens rápidas que você pode fazer no smartphone. Observe a naturalidade do olhar e das piscações: a ausência de piscadas ou um padrão mecânico é um sinal de alerta. Analise o lip-sync — se as consoantes plosivas (B, P, M) não são acompanhadas pelo contato labial esperado, é provável que haja manipulação. Outros detalhes, como microexpressões e micro-movimentos da cabeça, também costumam escapar aos geradores sintéticos.

Essas regras práticas não substituem ferramentas forenses, mas funcionam como filtros de triagem no dia a dia. Em termos de arquitetura digital, pense nesses testes como sensores na camada periférica de uma infraestrutura: capturam anomalias antes que o problema se propague pela rede social.

Finalmente, a melhor estratégia continua sendo uma combinação entre cultura cívica e tecnologia: treinar o olhar crítico, checar fontes primárias, usar ferramentas de detecção quando possível e não alimentar a cadeia de compartilhamento sem confirmação. O algoritmo como infraestrutura age rapidamente; nossa resposta precisa ser tão sistemática quanto o próprio sistema.

Em suma, reconhecer um deepfake exige atenção aos detalhes, conhecimento técnico básico e timing — porque, na batalha contra a desinformação, o tempo funciona como um condutor: quem atua rápido reduz o dano. Manter os alicerces digitais da confiança exige vigilância informada, não pânico.