Por Marco Severini — À distância de meses do ataque que ceifou oito vidas e deixou ao menos 25 feridos na escola de Tumbler Ridge, no Canadá, informações internas indicam que a OpenAI avaliou a possibilidade de notificar autoridades sobre interações de usuário com o ChatGPT cuja autoria foi atribuída à suspeita, Jesse Van Rootselaar. A revelação foi publicada pelo Wall Street Journal e reacende o debate sobre os limites entre privacidade, responsabilidade corporativa e segurança pública.

Fontes com conhecimento direto do processo relataram que, no mês de junho anterior ao ataque, Van Rootselaar manteve conversas por vários dias com o ChatGPT nas quais descrevia cenários de violência armada. Um sistema automático de monitoramento detectou esses conteúdos e os submeteu à revisão humana, provocando um debate interno entre cerca de dez funcionários da empresa.

Alguns colaboradores defenderam que as mensagens poderiam indicar risco real de violência e solicitaram que a direção informasse as autoridades canadianas. A liderança da companhia, porém, concluiu que a atividade não atendia aos requisitos para uma comunicação formal às forças de segurança — nomeadamente a exigência de um risco crível e iminente de dano físico grave. O perfil foi, em todo caso, suspenso.

Após a tragédia, a OpenAI entrou em contato com a Royal Canadian Mounted Police (RCMP) e declarou cooperação plena com as investigações, bem como pesar pelas vítimas. Ainda assim, a decisão anterior de não alertar a polícia volta a ser examinada nos alicerces da responsabilidade empresarial e da arquitetura normativa que orienta intervenções preventivas.

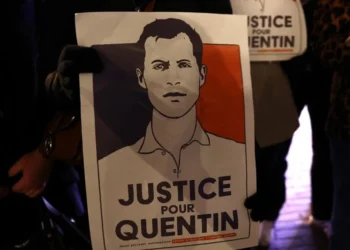

Jesse Van Rootselaar, de 18 anos, foi encontrada morta em 10 de fevereiro no interior da escola onde ocorreu o ataque, aparentemente por ferimento autoinfligido. A investigação aponta que a suspeita já era conhecida das autoridades locais por questões de saúde mental; armas haviam sido apreendidas temporariamente em sua residência em ações anteriores.

Os inquéritos seguem analisando o rastro digital da jovem em busca de indícios sobre o motivo do ataque. Entre os elementos identificados figuram um jogo não publicado na plataforma Roblox que simulava uma situação de tiro em shopping, imagens em estande de tiro e trocas de mensagens sobre armas e munição, inclusive alegações sobre a fabricação de um estojo de munição por impressora 3D.

O episódio reacende uma reflexão estratégica: qual é o papel das plataformas digitais e das empresas de inteligência artificial na prevenção de riscos coletivos? A OpenAI reforçou que seus modelos são projetados para desencorajar comportamentos danosos e que conversas que indiquem intenções violentas são submetidas à revisão humana, com notificações às autoridades apenas diante de um risco considerado iminente.

Num tabuleiro de dimensões sociais e tecnológicas, as peças se movimentam entre proteção de dados e dever de prevenir danos. A decisão de não avisar a polícia — tomada à luz dos critérios internos de risco — ressalta a fragilidade dos instrumentos atuais para antecipar comportamentos extremos e a necessidade de um redesenho dos mecanismos de cooperação entre setor privado e poder público, sem desconsiderar direitos fundamentais.

Enquanto as investigações prosseguem, permanece a exigência de respostas claras sobre protocolos, limiares e responsabilidades. Em termos de política pública, trata-se de ajustar as linhas mestras que regulam a segurança preventiva no espaço digital, preservando ao mesmo tempo a integridade jurídica e ética das intervenções.