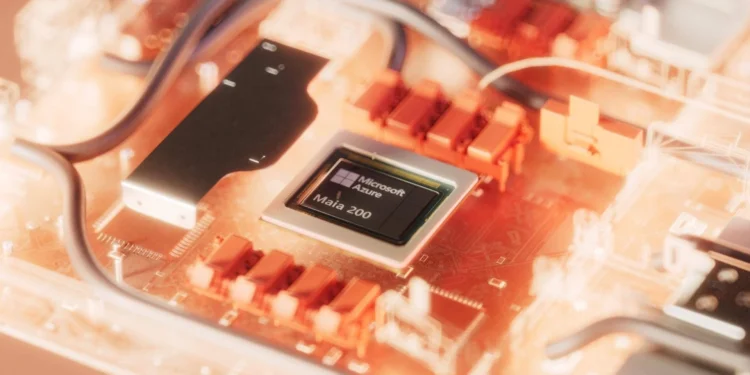

Por Riccardo Neri — A Microsoft apresentou o acelerador de IA Maia 200, projetado especificamente para a etapa crítica da inferência, quando os modelos transformam dados em respostas úteis em tempo real. Em termos práticos, este lançamento marca a transição da era de experimentação para a construção de alicerces digitais capazes de suportar serviços de larga escala com custos e consumo energético controlados.

Ao contrário do hardware herdado do treinamento — potente, porém frequentemente ineficiente para cargas de inferência — o Maia 200 nasce com um propósito claro: melhorar custo por resposta, reduzir latência e otimizar a eficiência elétrica para cenários de produção. Fabricado em processo de 3 nanômetros pela TSMC, cada chip integra mais de 140 bilhões de transistores, indicando uma densidade de lógica pensada para cargas distribuídas e intensivas em paralelismo.

O design do chip foca em três pilares de infraestrutura:

- Gestão de memória: arquitetura que mantém os dados o mais próximo possível dos núcleos de cálculo, minimizando gargalos de I/O e acessos à memória lenta — uma decisão arquitetural que afeta diretamente latência e consumo.

- Networking: interconexões reforçadas para reduzir a latência em cargas distribuídas entre nós, o que é essencial quando o modelo e o estado operam em camadas separadas de uma malha global.

- Formatação numérica: suporte otimizado a formatos reduzidos para processar operações com menor uso de energia e memória, sem comprometer acurácia nos casos de inferência generativa.

Segundo os dados divulgados, o sistema entrega cerca de 30% a mais de desempenho por dólar em comparação com hardware de última geração, permitindo executar modelos generativos complexos com menos chips e menor custo por resposta. Essa melhoria compõe a camada onde a IA se torna operacionalmente viável: menos chips por serviço, menos consumo por interação, e menos overhead operacional para escalar globalmente.

As primeiras unidades já estão em produção na região Azure US Central, com plano de expansão para US West 3 e outros pontos da malha global nos próximos meses. No plano de serviços, o Maia 200 suportará workloads do Microsoft 365 Copilot, geração de dados sintéticos e experiências da Microsoft Foundry, buscando manter a escalabilidade sem ampliar significativamente o consumo energético.

Do ponto de vista europeu e italiano, a chegada de aceleradores orientados à inferência é comparável à construção de um novo eixo de transmissão elétrica para a cidade: não é visível no dia a dia, mas reduzirá perdas, melhorará a entrega de serviços e tornará possível acomodar novas aplicações sem sobrecarregar a infraestrutura existente. A eficiência aqui não é só um ganho técnico; é a base para democratizar experiências de IA em serviços cotidianos, mantendo controle sobre custos e pegada energética.

Em resumo, o Maia 200 representa uma peça de infraestrutura — um componente do sistema nervoso digital — pensado para traduzir as camadas de inteligência em respostas eficientes e escaláveis. A eficácia dessa abordagem será medida na redução do custo por interação e na capacidade de integrar IA em larga escala sem elevar proporcionalmente o consumo ou o overhead operacional.